Show, attend and tell: Neural image caption generation with visual attention (ICML 2015)

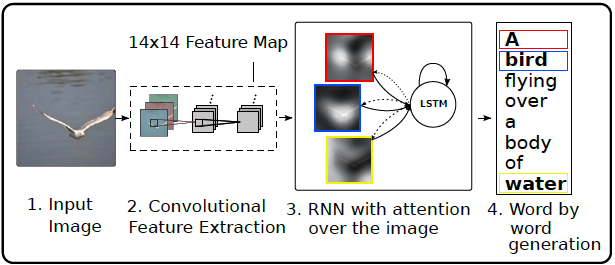

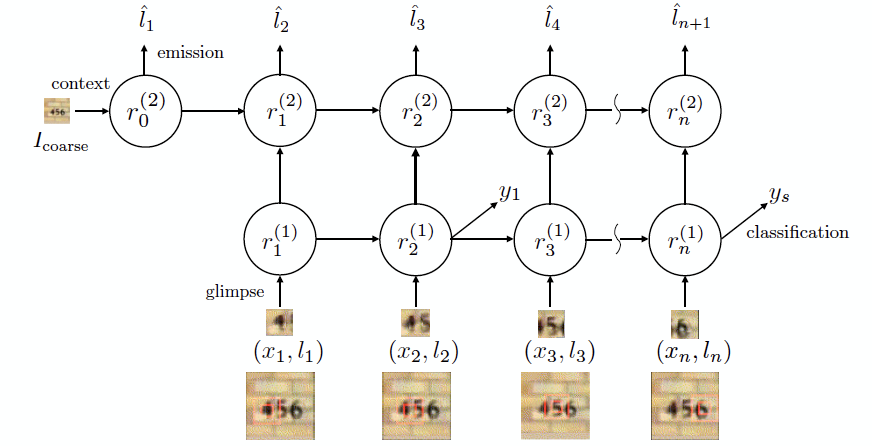

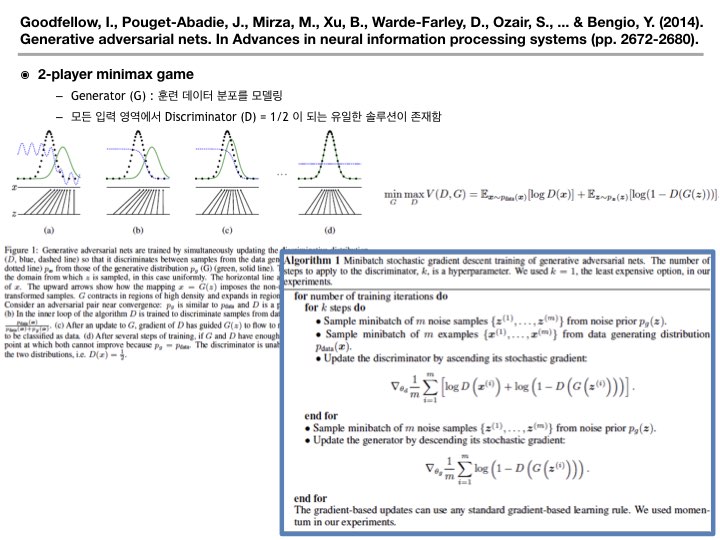

논문 제목: Show, attend and tell: Neural image caption generation with visual attention 주 저자: Kelvin Xu (몬트리올 대학) 참여 연구 기관: 몬트리올 대학, 토론토 대학 요즘 들어 주목받고 있는 attention model 에 관한 연구이다. Attention model 은 시계열 분석 모델에서 처음 적용되기 시작했다. 대표적인 논문 중 하나는 Bahdanau 가 기계 번역에 적용한 아래 논문이다. Bahdanau 는 기계 번역을 위해 Bi-LSTM 구조를 채용하고, 현재 시점을 중심으로 일정 time window 에 포함되는 LSTM hidden state 의 가중합으로 출력값을 추정한다. 이 때, hidden state 에 대한 가중치가 attention model 의 추정값이 된다. ( Bahdanau, D., Cho, K., & Bengio, Y. (2014). Neural machine translation by jointly learning to align and translate. arXiv preprint arXiv:1409.0473. ) [ Network Architecture ] 최근 들어 attention model 을 computer vision 분야에 적용하는 논문들이 발표되고 있다. 여기서 소개하는 논문은 이미지가 한 장 주어졌을 때, 이미지를 설명하는 문장을 생성하는 image captioning 기술에 관한 것이다. Image captioning을 위해서는 이미지 내에 어떠한 'context'가 내재되어 있는지 분석해야 한다. 본 논문에서는 context 분석 시 이미지 내에서 어느 위치를 주목해서 봐야하는지 attention model 을 이용하여 추정하고 있다. 아래 그림에서 본 논문의 전체적인 기술 구조를 도식화하였다. 위 그림...