Supervised contrastive learning. (arXiv 2020)

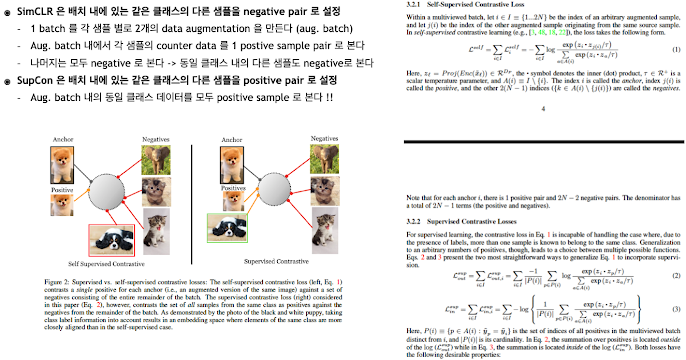

저자 : Khosla, P., Teterwak, P., Wang, C., Sarna, A., Tian, Y., Isola, P., ... & Krishnan, D. 연구기관 : Google, MIT SimCLR (A simple framework for contrastive learning of visual representations, PMLR 2020) 후속 논문이다. SimCLR의 단점을 보완하였다고 볼 수 있다.